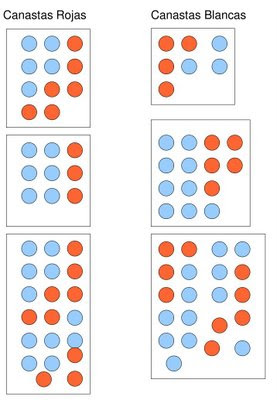

Un algoritmo muy usado desde el punto de vista pedagógico para justificar el hecho que la selección natural es un proceso acumulativo y no al azar es el conocido algoritmo acumulativo. El ejemplo parte de usar un mazo de cartas en las cuales se escoge ordenar de forma ascendente uno de los palos de la baraja. Esta ordenación conformaría la aparición de un nuevo organismo vivo, el cual se formaría de manera progresiva. El algoritmo es el siguiente:

1. Barajar las cartas.

2. si la primera carta es un as, entonces remover de la baraja

3. sino repetir 1 y 2

4. para i en 1, 2, 3, 4, … del palo dada

5. si la primera carta coincide con i, entonces remover de la baraja y adosar en forma ascendente al nuevo organismo

6. sino barajar las cartas y repetir 5

Al cabo de pocos minutos se obtiene un palo ordenado de cartas separado del mazo.

Esto se puede usar para poder justificar:

1. La selección no es un proceso que ocurra al azar

2. La evolución por selección natural es un proceso acumulativo

3. Solo las mutaciones son procesos al azar

Ahora bien, la vida como la conocemos se funda en un código genético basado en cuatro aminoácidos, donde cada terna (con sentido) de la línea de DNA está asociada a un aminoácido componente de una proteína, azúcar etc. Entonces según el punto de vista anterior la vida y la evolución no es más que un mero hecho mecánico totalmente computable. En esencia no sería muy diferente el mecanismo de producción de un organismo vivo a un control de temperatura de un horno, reduciendo todo a un proceso mecánico y recursivo.

Será así? o está faltando algo? como es posible que un proceso mecánico como lo es la generación de un ser vivo posibilite la aparición de la mente humana? El complejo comportamiento animal, es explicable por la herencia y la selección natural? Si bien el ojo es perfectamente explicable por el mecanismo de selección acumulativa, ya que es un sensor físico, pongo en duda lo referente a la mente tanto humana como animal. Creo que es un reduccionísmo excesivo por parte de los biólogos evolucionistas.